Искусственные нейронные сети, вдохновленные биологическими аналогами в нашем мозге, стали фундаментальным инструментом современного искусственного интеллекта. Однако за этим общим термином скрывается множество различных архитектур, каждая из которых была создана для решения конкретного класса задач. Понимание того, какие цели преследуют разработчики при создании той или иной нейросети, позволяет не только лучше осознать принципы их работы, но и выбрать правильный инструмент для решения практических проблем. От распознавания образов на фотографиях до генерации целых статей, от прогнозирования временных рядов до создания фотореалистичных изображений — каждая цель требует своего уникального подхода. В этой статье мы подробно рассмотрим основные типы нейросетей, их внутреннюю логику и те многочисленные области, где они уже сегодня демонстрируют выдающиеся результаты.

Содержание

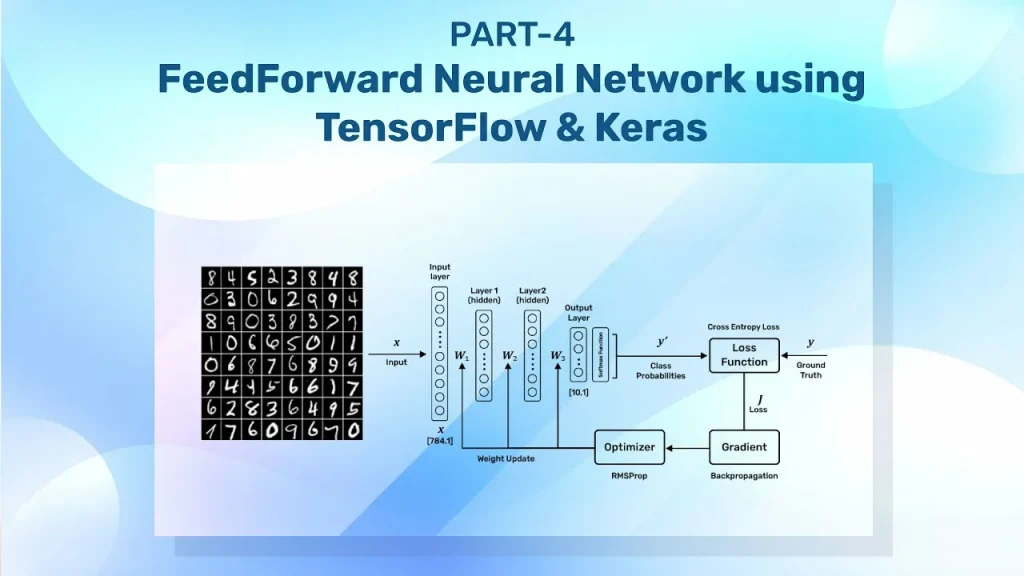

Feedforward-сети: фундамент предсказаний

Самой базовой и исторически первой архитектурой является feedforward-нейронная сеть (FNN). Ее принцип работы удивительно прост и линеен: информация движется строго в одном направлении — от входного слоя через один или несколько скрытых слоев к выходному слою, без каких-либо обратных связей или петель. Эта кажущаяся простота, однако, не мешает FNN быть чрезвычайно мощным инструментом для широкого спектра задач, где требуется установить сложную, нелинейную зависимость между входными данными и желаемым результатом.

Основная цель таких сетей — это построение надежных предиктивных моделей. Они идеально подходят для задач регрессии, где необходимо предсказать непрерывное числовое значение (например, цену на недвижимость на основе ее характеристик или коэффициент трения в инженерных системах), а также для задач классификации, где нужно отнести объект к одной из заранее определенных категорий (например, определить, является ли электронное письмо спамом, или диагностировать заболевание по медицинским показателям). Благодаря своей способности к универсальной аппроксимации, FNN могут моделировать практически любую функцию, что делает их универсальным «рабочим конем» в машинном обучении. Их применяют в самых разных областях: от финансового моделирования и анализа рисков до биологической инженерии, например, для оптимизации условий в гидропонных системах выращивания растений.

Хотя более сложные архитектуры, такие как CNN и RNN, затмили FNN в своих узких областях, feedforward-сети остаются неотъемлемой частью многих гибридных моделей и служат основой для понимания более продвинутых концепций в глубоком обучении. Их главная сила — в способности эффективно обрабатывать структурированные данные, где каждый входной признак имеет четкое значение, и последовательность или пространственная структура данных не играют ключевой роли.

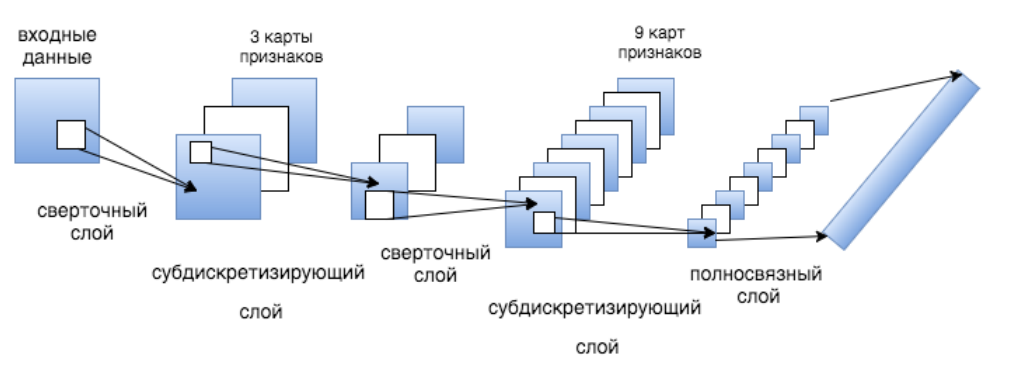

Сверточные нейросети: глаза искусственного интеллекта

Если feedforward-сети — это универсальный инструмент для предсказаний, то сверточные нейронные сети (CNN) были специально созданы для одной великой цели: понимания визуального мира. Их архитектура напрямую вдохновлена организацией зрительной коры головного мозга и предназначена для эффективной обработки данных, имеющих сетчатую топологию, в первую очередь — изображений.

Ключевым элементом CNN являются сверточные слои, которые применяют небольшие фильтры (ядра свертки) ко всему изображению, скользя по нему и выявляя локальные особенности, такие как края, углы или текстуры. По мере прохождения данных через последовательные слои сеть учится распознавать все более сложные и абстрактные паттерны: от простых линий до форм, а затем и до целых объектов, таких как лица, автомобили или животные. Эта иерархическая обработка информации, сочетающаяся с операциями пулинга (уменьшения размерности), позволяет CNN быть невероятно эффективными в задачах компьютерного зрения.

Их основное применение — это классификация изображений, детекция объектов (определение местоположения и типа нескольких объектов на одном снимке), сегментация (точное выделение границ объектов на пиксельном уровне) и распознавание лиц. Эти технологии лежат в основе автопилотов беспилотных автомобилей, систем медицинской диагностики (анализ рентгеновских снимков и МРТ), фильтров в социальных сетях и систем безопасности.

Интересно, что успех CNN оказался настолько велик, что исследователи начали адаптировать их и для задач, далеких от обработки изображений. Например, в обработке естественного языка (NLP) текст можно рассматривать как одномерный «сигнал», и сверточные фильтры могут эффективно выявлять локальные семантические паттерны для задач классификации текста, анализа тональности или даже ответов на вопросы.

Таким образом, хотя первоначальная цель CNN была сосредоточена на зрении, их способность находить локальные зависимости в структурированных данных сделала их одним из самых универсальных и широко используемых типов нейросетей.

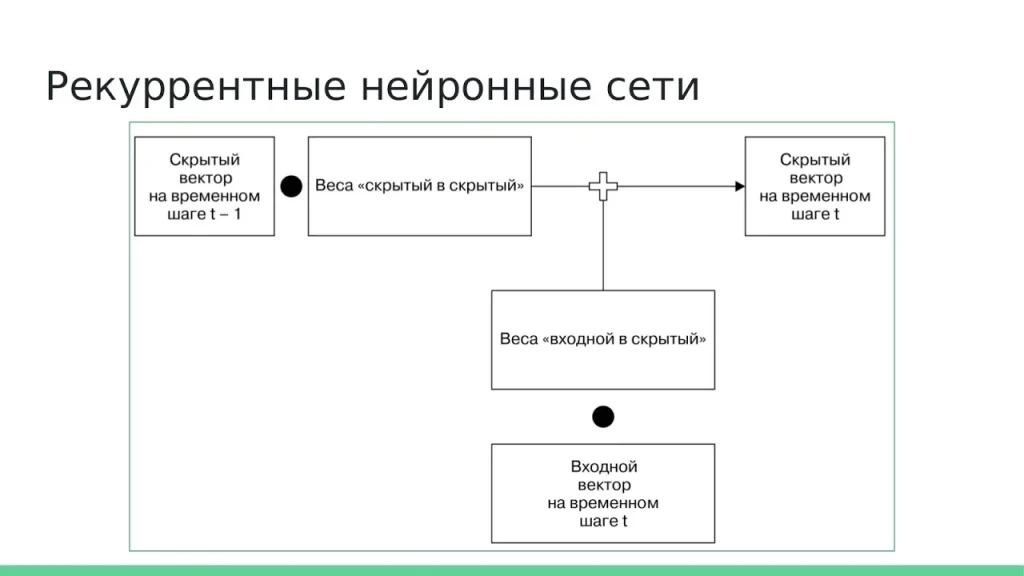

Рекуррентные нейросети: память для последовательностей

В отличие от feedforward- и сверточных сетей, которые обрабатывают все входные данные одновременно, рекуррентные нейронные сети (RNN) были разработаны с совершенно иной целью: работать с последовательностями. Их ключевая особенность — наличие внутреннего состояния (памяти), которое передается от одного шага последовательности к другому. Это позволяет RNN учитывать контекст: выход на текущем шаге зависит не только от текущего входа, но и от всей истории предыдущих входов. Такая архитектура делает их идеальными для задач, где порядок данных имеет критическое значение.

Основная сфера применения RNN — это обработка естественного языка (NLP). Здесь они используются для машинного перевода, где важно понимать контекст целого предложения, для генерации текста, для создания подписей к изображениям и для распознавания речи, где звуковые сигналы поступают в виде временной последовательности. Кроме того, RNN незаменимы в прогнозировании временных рядов — будь то предсказание цен на акции, погоды или спроса на товары, так как они могут выявлять и использовать долгосрочные зависимости в данных.

Однако классические RNN сталкиваются с серьезной проблемой, известной как «исчезающие градиенты», которая затрудняет обучение на очень длинных последовательностях. Для решения этой проблемы были разработаны специализированные архитектуры, такие как LSTM (Long Short-Term Memory) и GRU (Gated Recurrent Unit), которые используют сложные механизмы «ворот» для более эффективного управления потоком информации и долгосрочной памятью.

Именно благодаря этим усовершенствованиям, нейросети для написания текста достигли такого высокого уровня, способного генерировать связные и тематически релевантные абзацы, эссе и даже художественные произведения. Хотя в последние годы их место в некоторых NLP-задачах заняли трансформеры, RNN и их варианты остаются важным инструментом для работы с последовательными данными, особенно в тех случаях, где вычислительные ресурсы ограничены.

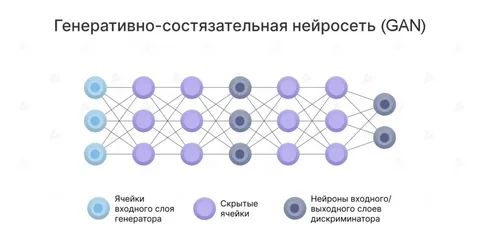

Генеративно-состязательные сети: искусство и синтез данных

Генеративно-состязательные сети (GAN) представляют собой радикально иной подход к обучению нейросетей. Вместо того чтобы учиться на готовых парах «вход-выход», GAN состоит из двух сетей, вовлеченных в постоянную игру: генератора и дискриминатора. Генератор стремится создавать поддельные данные (например, изображения), которые были бы неотличимы от реальных, в то время как дискриминатор пытается отличить подделку от оригинала. В процессе этого состязания обе сети постоянно улучшаются: генератор становится все более искусным в создании реалистичных данных, а дискриминатор — в их распознавании.

Главная цель GAN — это генерация новых, ранее не существовавших данных, которые принадлежат к тому же распределению, что и обучающий набор. Это открыло двери в мир синтетического творчества и решения проблемы нехватки данных.

Основные применения GAN включают синтез фотореалистичных изображений людей, которые никогда не существовали, создание произведений искусства в заданном стиле (перенос стиля), улучшение качества изображений (суперразрешение), генерацию изображений по текстовому описанию (text-to-image) и создание аниме-персонажей. В медицине GAN используют для генерации синтетических медицинских изображений для обучения других моделей, когда реальные данные конфиденциальны или их недостаточно. В индустрии видеоигр они помогают создавать новые текстуры, персонажей и даже целые миры. GAN также нашли применение в кибербезопасности для генерации реалистичных примеров атак с целью обучения систем защиты.

Эта архитектура кардинально изменила представление о том, что нейросети могут не только анализировать, но и творить, генерируя качественно новый контент.

Трансформеры: новая эра обработки последовательностей

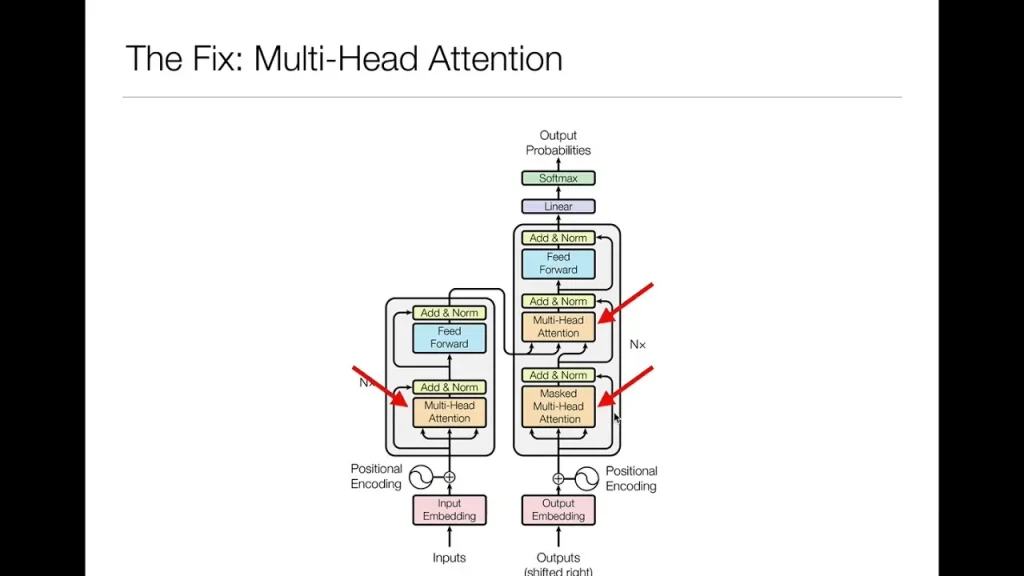

Появившись в 2017 году в работе «Attention is All You Need», архитектура трансформеров совершила революцию в области обработки последовательностей, особенно в NLP. Их главная цель — преодолеть ключевые ограничения RNN, такие как невозможность параллельной обработки последовательности и трудности с захватом очень долгосрочных зависимостей. Трансформеры достигают этого за счет механизма внимания (attention mechanism), который позволяет модели динамически взвешивать важность всех слов в последовательности при обработке каждого отдельного слова, независимо от их расстояния друг от друга. Это означает, что для понимания смысла слова в конце предложения модель может напрямую «взглянуть» на ключевое слово в его начале, минуя все промежуточные слова. Такой подход не только значительно повышает качество, но и позволяет обрабатывать всю последовательность параллельно, что ускоряет обучение на порядки.

Трансформеры стали основой для всех современных крупных языковых моделей (LLM), таких как GPT и BERT, которые доминируют в задачах машинного перевода, суммаризации текста, генерации текста и ответов на вопросы. Их успех был настолько велик, что архитектуру трансформеров начали успешно применять и за пределами NLP. Vision Transformers (ViT) показали, что механизм внимания может быть эффективно использован и для обработки изображений, разбивая их на последовательность «патчей» и обрабатывая их как слова в предложении, достигая результатов, сопоставимых или превосходящих лучшие CNN в задачах классификации изображений.

Сегодня трансформеры применяются в самых разных областях, включая обработку аудио, биоинформатику и многомодальное обучение (одновременная работа с текстом, изображениями и другими типами данных), что делает их одной из самых универсальных и перспективных архитектур в современном ИИ.

Вот ключевые типы нейросетей и их основные цели:

- Feedforward Neural Networks (FNN): предсказание и классификация на основе структурированных данных.

- Convolutional Neural Networks (CNN): анализ и понимание данных с пространственной структурой (изображения, видео).

- Recurrent Neural Networks (RNN/LSTM/GRU): обработка и генерация последовательных данных с учетом контекста (текст, речь, временные ряды).

- Generative Adversarial Networks (GAN): генерация новых, реалистичных данных путем состязательного обучения.

- Transformers: масштабируемая и высокоточная обработка последовательностей и других данных с помощью механизма внимания.

Мир нейронных сетей — это не монолитная структура, а богатая экосистема специализированных архитектур, каждая из которых возникла для решения конкретных задач. От простых, но надежных feedforward-сетей для предсказаний до сложных трансформеров, способных понимать и генерировать человеческий язык, выбор правильного инструмента определяет успех любого проекта в области искусственного интеллекта. Понимание целей, для которых были созданы CNN, RNN, GAN и трансформеры, позволяет не просто механически применять их, но и осознанно комбинировать, адаптировать и разрабатывать новые решения. Будущее, вероятно, будет принадлежать гибридным моделям, которые объединяют сильные стороны разных архитектур, но фундаментальное знание их предназначения останется ключом к открытию новых возможностей ИИ.