В последние десятилетия облачные вычисления стали неотъемлемой частью современной информационной инфраструктуры. Они предоставляют компаниям и разработчикам доступ к масштабируемым вычислительным ресурсам без необходимости инвестировать в дорогостоящее оборудование. Одной из наиболее интересных и перспективных областей облачных технологий является использование графических процессоров (GPU) для выполнения задач, требующих высокой вычислительной мощности. В данной статье рассмотрим, почему облачные вычисления на GPU стали столь популярными, как они работают, и в каких областях их применение наиболее востребовано.

Содержание

Что такое GPU и чем он отличается от CPU

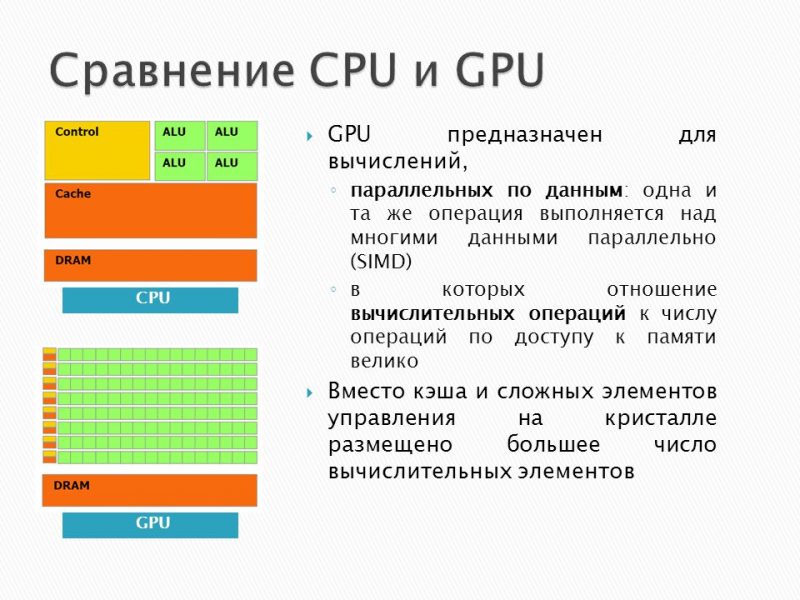

Графические процессоры (GPU) изначально разрабатывались для обработки графики и выполнения сложных операций с изображениями, таких как рендеринг трёхмерных моделей и реализация эффектов в видеоиграх. Однако их архитектура, оптимизированная для параллельных вычислений, делает их также чрезвычайно эффективными для научных расчетов, машинного обучения и анализа больших данных.

Ключевое отличие GPU от центрального процессора (CPU) заключается в их архитектуре. CPU имеют несколько мощных ядер, предназначенных для последовательного выполнения задач, тогда как GPU содержат тысячи менее мощных ядер, которые могут выполнять множество операций одновременно. Эта особенность делает GPU идеальными для задач, где важна массовая параллельная обработка данных.

Преимущества использования GPU в облачных вычислениях

GPU значительно превосходят CPU по производительности в задачах, связанных с параллельной обработкой данных. Например, в области машинного обучения использование GPU позволяет ускорить обучение нейронных сетей в десятки раз по сравнению с CPU.

Облачные платформы предоставляют возможность использовать столько GPU, сколько необходимо для выполнения задачи. Пользователи могут легко масштабировать ресурсы в зависимости от текущих потребностей, избегая затрат на покупку и обслуживание оборудования.

Облачные вычисления на GPU позволяют компаниям и исследовательским группам получать доступ к мощным вычислительным ресурсам без необходимости значительных капитальных вложений. Оплата происходит только за фактически использованное время работы.

Современные облачные платформы предлагают разнообразные типы GPU, включая специализированные модели для задач машинного обучения, графической обработки или научных расчетов. Это позволяет выбрать оптимальное решение для каждой конкретной задачи.

Основные облачные платформы для вычислений на GPU

Рынок облачных вычислений предлагает множество решений, позволяющих использовать GPU. Рассмотрим наиболее популярные из них:

- Amazon Web Services (AWS). AWS предлагает мощные виртуальные машины с GPU через сервис EC2 (Elastic Compute Cloud). Среди доступных GPU можно выделить NVIDIA A100, V100 и T4, которые оптимизированы для различных сценариев, включая машинное обучение и рендеринг.

- Google Cloud Platform (GCP). GCP предоставляет облачные вычислительные ресурсы с поддержкой GPU через Compute Engine и Kubernetes Engine. Сервисы поддерживают работу с популярными фреймворками машинного обучения, такими как TensorFlow и PyTorch.

- Microsoft Azure. Azure также предлагает широкий спектр виртуальных машин с GPU. Например, серии NC и ND предназначены для задач глубокого обучения и симуляций, тогда как NV-серия оптимизирована для графических приложений.

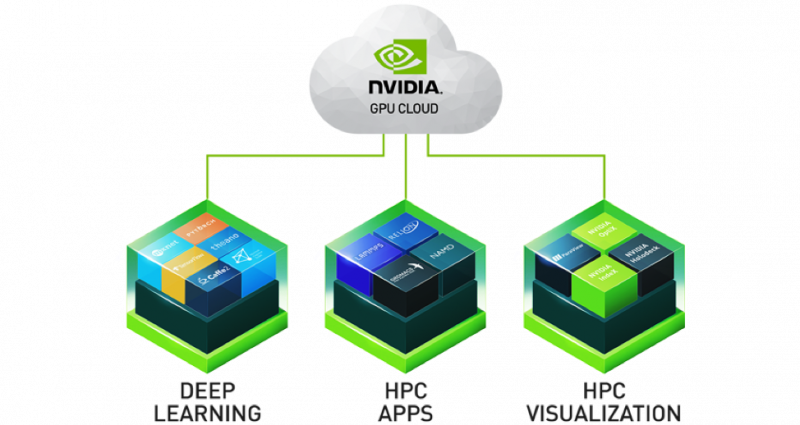

- NVIDIA GPU Cloud (NGC). Это специализированное решение от NVIDIA, ориентированное на предоставление GPU в облаке. Платформа предлагает преднастроенные контейнеры и оптимизированные библиотеки для задач машинного обучения, анализа данных и графической обработки.

Области применения облачных вычислений на GPU

Одной из главных причин роста популярности GPU в облаке стало их применение в области искусственного интеллекта (ИИ). Обучение глубоких нейронных сетей требует выполнения большого количества матричных операций, которые идеально подходят для архитектуры GPU. Благодаря облачным платформам разработчики могут быстро развертывать масштабные модели, такие как GPT или BERT, без необходимости покупать дорогое оборудование.

GPU активно используются в научных расчетах, таких как моделирование физических процессов, биоинформатика и анализ данных из телескопов. Например, в области биоинформатики облачные GPU применяются для расшифровки геномов и моделирования белков.

Рендеринг высококачественной графики, создание спецэффектов для фильмов и игр — все это требует значительных вычислительных ресурсов. Облачные GPU позволяют выполнять такие задачи быстрее и дешевле, особенно в условиях жестких сроков.

В финансовой отрасли GPU используются для выполнения сложных расчетов, таких как моделирование финансовых рисков, анализ больших объемов данных и оптимизация портфелей.

С ростом числа устройств IoT увеличивается потребность в обработке больших объемов данных в реальном времени. GPU в облаке помогают справляться с этой задачей, позволяя обрабатывать потоки данных с датчиков, видеокамер и других устройств.

Проблемы и вызовы

Несмотря на все преимущества, использование GPU в облачных вычислениях сталкивается с рядом проблем:

- Высокая стоимость: хотя облачные вычисления экономически выгодны для временных задач, длительное использование GPU может стать дорогостоящим.

- Проблемы с латентностью: передача данных между локальными устройствами и облаком может быть ограничена скоростью сети, что особенно критично для задач реального времени.

- Сложность настройки: оптимизация приложений для работы с GPU требует специальных знаний и навыков, что может стать барьером для некоторых пользователей.

- Безопасность данных: передача и обработка конфиденциальных данных в облаке требуют дополнительных мер безопасности.

Перспективы развития

С развитием технологий облачные вычисления на GPU продолжат расширять свои возможности. Появление новых поколений GPU, таких как NVIDIA H100, позволит еще больше увеличить производительность и снизить энергопотребление. Также ожидается развитие специализированных облачных сервисов для конкретных задач, таких как обучение больших языковых моделей или анализ медицинских данных.

Кроме того, усилия по интеграции квантовых вычислений с облачными GPU могут открыть новые горизонты в обработке данных и моделировании сложных систем.

Облачные вычисления на GPU представляют собой мощный инструмент для решения самых сложных задач современности. Благодаря их высокой производительности, гибкости и доступности, они находят применение в самых разных областях — от науки и медицины до развлекательной индустрии и финансов. Несмотря на существующие вызовы, такие как высокая стоимость и сложности настройки, будущее облачных GPU выглядит весьма многообещающе. Организации, которые сумеют эффективно использовать эти технологии, получат значительные преимущества в своей деятельности.